코딩하는 해맑은 거북이

[선형대수학] 인공지능을 위한 선형대수 (3) 본문

본 게시물의 내용은 '인공지능을 위한 선형대수(주재걸 교수님)' 강의를 듣고 작성하였다.

해당 글은 아래의 4가지를 다룬다.

1. 부분공간(Subspace)

2. 기저(Basis)와 차원(Dimension)

3. 계수(Rank)

4. 선형변환(Linear Transformation)

- 부분공간의 기저와 차원

- Subspace(부분공간)

: n차원 공간에 대해, n차원 공간에 포함되면서 n차원 벡터들에 대해 선형결합 연산이 성립되는 작은 공간

- 기저벡터(Basis)

: subspace H를 Fully span 하면서 선형 독립인 벡터들의 집합

- 부분공간의 기저벡터는 Unique 하지 않다는 특성을 가지고 있다.

- Dimension of Subspace

: subspace가 주어져 있을 때, Subspace의 기저벡터의 갯수

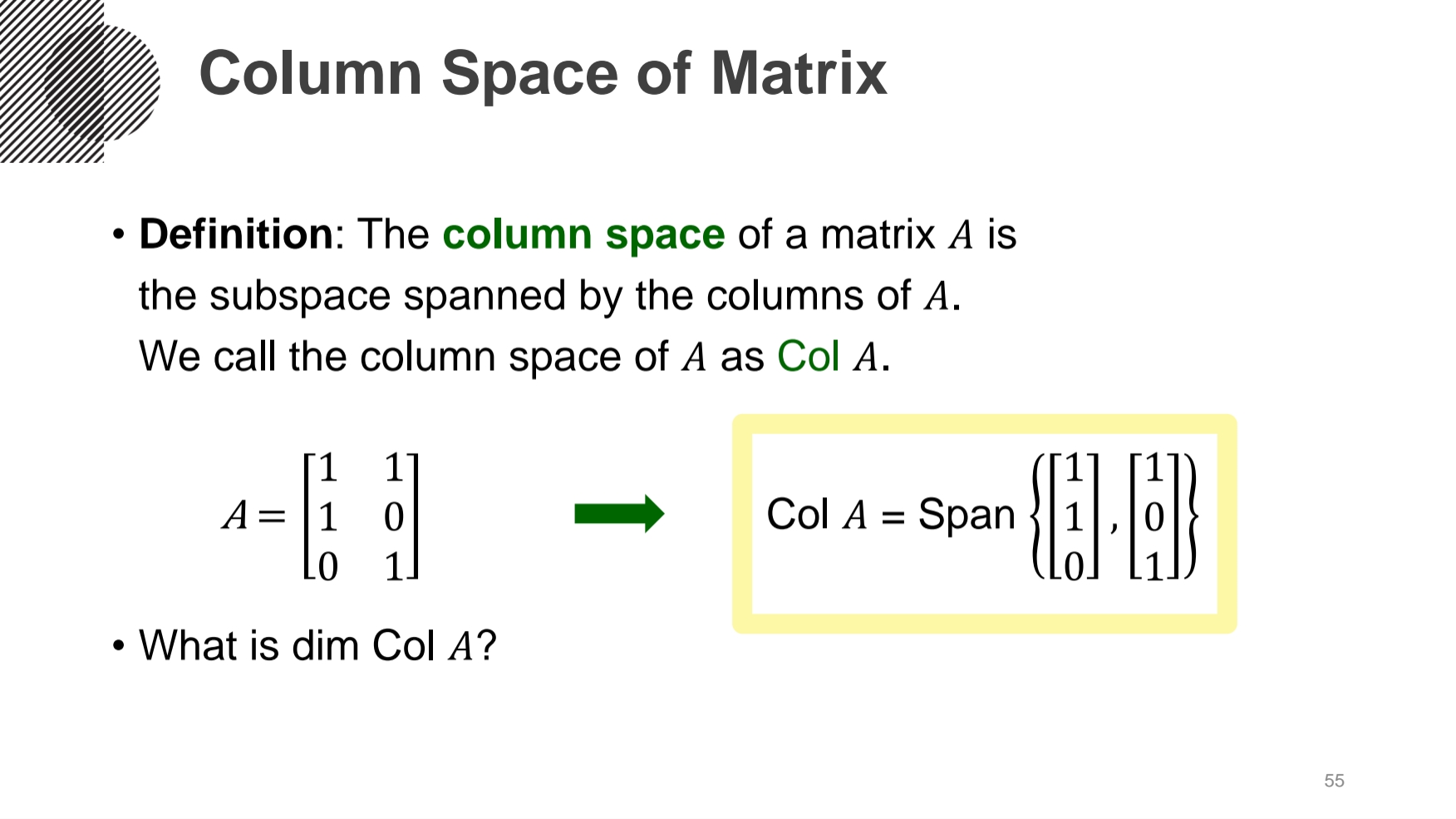

- Coulmn space

: Column 벡터들의 Span

행렬 A가 있을 때, 이를 Column space로 표현하고자 한다.

그때, 3번째 Column vector가 나머지 2개의 Column vector의 선형결합으로 표현된다면, 이는 Column Space의 공간에서 지우고 나타낼 수 있다.

- Rank

: Column space의 dimension, 즉 Column space의 기저벡터의 갯수

- Feature의 수보다 Rank가 작으면 일부 Feature들이 선형종속 관계라는 뜻이다.

즉, 실질적인 정보가 없는, 중복된 정보인 Feature가 포함되어 있다는 뜻.

- 선형변환

- 선형변환(Linear Transformation)

:

- 1차원에서 1차원으로의 변환은 선형변환이 아니지만, 2차원에서 1차원으로의 변환은 선형변환을 만족한다.

- 선형성을 만족하는 변환이란, 어떤 행렬을 주어진 입력벡터와의 곱으로 항상 나타낼 수 있다.

즉, 벡터의 선형변환은 행렬의 곱으로 항상 표현될 수 있다.

'Mathematics | Statistics' 카테고리의 다른 글

| [선형대수학] 인공지능을 위한 선형대수 (6) (0) | 2022.07.19 |

|---|---|

| [선형대수학] 인공지능을 위한 선형대수 (5) (0) | 2022.07.18 |

| [선형대수학] 인공지능을 위한 선형대수 (4) (0) | 2022.07.17 |

| [선형대수학] 인공지능을 위한 선형대수 (2) (0) | 2022.07.14 |

| [선형대수학] 인공지능을 위한 선형대수 (1) (0) | 2022.07.13 |

Comments